Qu’il s’agisse d’effectuer des recherches sur Google, de discuter avec Alexa ou de regarder du contenu sur Instagram, cela fait maintenant des années que l’intelligence artificielle fait partie intégrante de nos vies. Au cours de la dernière décennie, les innovations mises en œuvre dans les domaines du calcul, du stockage et de la disponibilité des données ont tout particulièrement contribué à l’accélération de ce que l’on appelle l’apprentissage automatique.

Par Peter Choi, Senior Research Analyst, Davit Khachatryan, Research Analyst et Chul Chang, Portfolio Manager, Senior Research Analyst

Pourquoi ce cycle particulier de l’IA se trouve-t-il au centre de tant d’attention?

L’IA générative représente une nouvelle classe d’IA dont la caractéristique essentielle réside dans sa capacité à mieux comprendre le langage et à créer des contenus originaux. L’IA générative est, de fait, en mesure de créer des textes, des images et des sons ressemblant à ceux que pourraient produire un être humain, et ce, sans pour autant reposer sur une programmation explicite. Fort de sa capacité à interagir avec les humains en contexte conversationnel, le chatbot ChatGPT a constitué le premier modèle d’IA générative à gagner en popularité.

S’il est d’ores et déjà acquis que la plupart des secteurs intégreront l’IA générative, cette dernière ne devrait pas nécessairement modifier de manière fondamentale la nature de leurs activités. L’impact concernera essentiellement l’efficacité. Quant à la capacité des sociétés à conserver les gains de productivité réalisés grâce à l’IA générative, elle dépendra de l’intensité de la concurrence, à tel point que, dans les secteurs concurrentiels, les avantages de l’IA finiront par être dissipés. C’est dans le secteur de la technologie que des impacts substantiels sont les plus susceptibles de se produire, car l’IA générative s’y trouve plus directement liée à l’offre produits que peuvent proposer les sociétés de ce secteur. Théoriquement, l’IA générative devrait stimuler davantage la demande portant sur les infrastructures informatiques déjà sollicitées pour le deep learning.

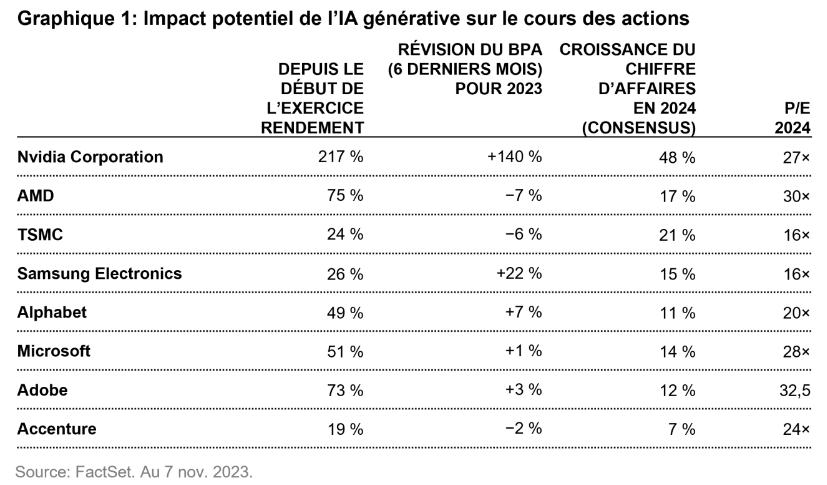

L’IA a joué un rôle moteur de tout premier plan dans l’évolution des rendements des actions du secteur technologique cette année. Les investisseurs se sont en effet concentrés sur les sociétés les plus exposées à l’IA (c.-à-d. sur celles qui adoptent le plus le calcul accéléré), ainsi que sur celles présentant des aspects spéculatifs. Bien que cela présente une certaine logique, il est particulièrement difficile, à ce stade encore précoce, de quantifier l’impact qu’aura l’IA à moyen terme, et il est important d’avoir à l’esprit le fait que les fluctuations des résultats pourront avoir un impact significatif sur les anticipations pour chacune des sociétés considérées dans leur ensemble. Se montrant incapables d’évaluer avec certitude les avantages que pourrait avoir l’IA à long terme, les marchés ont récompensé certaines sociétés de manière disproportionnée par rapport à d’autres. À titre d’exemple, la forte hausse du cours des titres NVIDIA et AMD enregistrée cette année indique que les investisseurs estiment que ces deux sociétés devraient bénéficier de l’adoption accrue de l’IA. Mais cela ne serait pas possible sans TSMC, qui est le principal fabricant des puces semi-conductrices complexes qui permettent à l’IA de fonctionner non seulement pour NVDIA, mais aussi pour des géants technologiques tels que Google et Microsoft.

Lorsqu’il s’agit d’évaluer l’impact de l’IA générative, c’est sur les cas d’utilisation facilement réalisables que nous nous concentrons plutôt que de rêver aux possibilités à long terme. L’IA générative n’en est encore qu’aux tout premiers stades de son développement et de son adoption, et, compte tenu de la puissance des grands modèles de langage (LLM)1, certains types de tâches sont plus immédiatement réalisables dans les domaines de l’aide à la rédaction, au résumé, à la création de contenu, etc. Dans le même temps, les itérations actuelles des LLM ne sauraient être considérées comme «intelligentes» au sens classique du terme, car elles agissent davantage comme des machines de correspondance de motifs incroyablement complexes, si bien qu’elles peuvent être sujettes à des erreurs et avoir ce que l’on appelle des «hallucinations». Ces limites font que les LLM se prêtent mieux à la réalisation de tâches plus étroitement définies et pour lesquelles les données et la formation peuvent apporter une plus grande cohérence. Cela convient également à des cas d’utilisation axés sur les entreprises, notamment parce que les entreprises sont prêtes à payer pour obtenir des gains d’efficacité. Plusieurs de nos participations dans le secteur technologique ont intégré de nouvelles capacités d’IA générative dans leurs portefeuilles de produits existants; cela leur permet d’optimiser les atouts dont elles disposent déjà (capacités traditionnelles, distribution, p. ex.) afin de générer une croissance plus durable des bénéfices.

L’engouement manifesté à l’égard des sociétés pouvant bénéficier de l’IA générative doit s’accompagner d’une stricte discipline lorsqu’il s’agit de procéder à l’évaluation de ces sociétés. L’augmentation des bénéfices portés par l’IA devrait pouvoir s’observer au cours des années à venir. Mais, l’impact éventuel que cela pourrait avoir sur le cours des actions dépendra de la capacité qu’auront les sociétés à utiliser l’IA pour accroître leurs bénéfices. En tant qu’investisseurs, nous privilégions les entreprises affichant un niveau élevé de prévisibilité et bien positionnées pour bénéficier de la croissance structurelle observée au sein de ce secteur, car cela garantit des rendements financiers plus réalistes et mesurables.

Nous examinons dans cet article les cas de six sociétés – Microsoft, Google, Adobe, TSMC, Samsung Electronics et Accenture – qui nous semblent appelées à connaître une croissance mesurée et à long terme de leurs bénéfices grâce à l’IA générative, et au sujet desquelles nous avons pris en compte un large éventail de risques.

Microsoft est considéré comme l’un des principaux bénéficiaires de l’IA dans le domaine des logiciels

Les investisseurs estiment que Microsoft affiche de nombreux domaines de croissance ne présentant pas de vulnérabilités apparentes significatives. La stratégie de Microsoft consiste à présenter les fonctions d’IA sous la forme de références IA distinctes proposées à des prix élevés. Ces références ont été baptisées Copilot et mettent l’accent sur les capacités d’assistance de la technologie.

GitHub Copilot (codage assisté) est un outil qui génère du code et qui est également utile pour le débogage, l’explication, la documentation et la traduction de codes. GitHub Copilot est un outil permettant de compléter automatiquement du code et d’accélérer ainsi le «premier jet» initial, même si le gain de temps se trouve partiellement contrebalancé par des exigences de débogage et de réécriture plus importantes. Bien que le code suggéré puisse encore présenter des problèmes ayant trait au contexte, à l’efficacité et à la sécurité, la proposition de valeur semble claire du fait des avantages significatifs qu’il propose en matière de productivité, notamment pour les développeurs de logiciels rares et bien rémunérés.

Office Copilot représente le plus grand levier potentiel de l’IA, car cet outil propose des fonctionnalités telles que la rédaction ou l’édition de mémos, la réponse à des e-mails, la création de présentations PowerPoint se fondant sur des fichiers existants, ou l’utilisation d’Excel pour analyser des données et créer des graphiques. Office Copilot devrait également pouvoir servir d’interface basée sur le langage naturel et permettre ainsi aux utilisateurs de tirer parti de toutes les capacités qu’offre la suite Office.

Le degré de pénétration de Copilot pourrait se révéler relativement modeste au début, car les sociétés mettront sans doute du temps à comprendre comment les tâches pilotées par l’IA permettent d’améliorer l’efficacité d’un plus grand nombre de cols blancs et à quel point cette efficacité profite réellement aux sociétés qui les emploient. Cet outil ne sera disponible que pour les utilisateurs de la suite M365, ce qui représente environ 160 millions de postes sur les 382 millions de postes Office365.

Parmi ses autres applications, Microsoft a annoncé l’outil Dynamics Copilot, qui propose des fonctions d’IA pouvant être utilisées pour les services commerciaux (contenu d’e-mail personnalisable, résumés de réunions), le service client (résolution de problèmes de clients, agents virtuels), le marketing (connaissance des données clients, segments d’audience, rédaction) et la gestion de la chaîne d’approvisionnement. Le Security Copilot de Microsoft est conçu pour aider à détecter des incidents, à enquêter à leur sujet et à les documenter.

L’IA devrait également stimuler la demande pour le Cloud public Azure de Microsoft. Les clients peuvent obtenir un accès aux modèles de base d’Open AI (GPT, Codex, DALL-E) ainsi qu’à des API permettant d’exécuter certaines tâches spécifiques (reconnaissance d’images, sécurité du contenu, traduction vocale, p. ex.). En plus de payer pour les modèles propriétaires de Microsoft, les clients peuvent tout simplement utiliser l’infrastructure informatique d’Azure pour faire tourner des modèles open source ou leurs propres modèles.

Il est plus difficile d’estimer l’impact que pourrait avoir Azure sur le chiffre d’affaires du groupe, car le nombre d’inconnues est plus élevé. Alors que l’utilisation des modèles d’IA est appelée à s’intensifier, le coût de l’inférence diminue rapidement à mesure que les sociétés réalisent des gains d’efficacité. En matière de parts de marché, un certain nombre d’incertitudes demeurent quant à la part des tâches qui seront effectuées à l’aide de modèles de pointe par rapport à celles qui le seront en recourant à des modèles open source formés pour un domaine spécifique et «suffisamment performants». Chaque modèle peut en outre être décliné en différentes tailles selon les exigences de performance. Cela étant, alors qu’Azure a généré 57 milliards de dollars de chiffre d’affaires au cours de l’exercice 2023, ou près de 43 milliards de dollars si l’on en exclut la partie SaaS, cette plateforme applicative dématérialisée de Microsoft pourrait, dans quelques années, générer 6 milliards de dollars de chiffre d’affaires supplémentaires dans le domaine de l’IA.

Pour Microsoft, qui a généré un chiffre d’affaires total de 212 milliards de dollars au cours de l’exercice 2023, le chiffre d’affaires de l’IA pourrait s’élever à environ 20 milliards de dollars2. Cela représenterait une hausse de 9% du chiffre d’affaires actuel, mais le rythme initial d’adoption pourrait n’augmenter que progressivement, au fur et à mesure que les clients se familiariseront avec ce nouveau type de produit. Dans l’hypothèse d’une montée en puissance s’étalant sur 4 à 5 années, cela contribuerait à hauteur d’environ 2% à la croissance du chiffre d’affaires et d’environ 3% à la croissance du BPA au cours de la période.

Google bénéficie de l’intégration de l’IA dans ses franchises

Au vu de la capacité apparente de ChatGPT à répondre à des questions portant sur n’importe quel sujet, le lancement initial de cette IA générative a soulevé un certain nombre de questions quant aux implications que cela pouvait avoir pour Google. D’autant que Microsoft a dévoilé une version remaniée de Bing, axée sur le système GPT-4. Malgré un lancement très médiatisé en début d’année, le nouveau Bing n’est toutefois pas parvenu à entailler de manière perceptible les résultats de Google. Depuis le début de l’année, la part de marché mondiale de Google est en effet restée stable à 92-93%, contre 3%, environ, pour Bing.

Google occupe une position de tout premier plan dans le domaine du deep learning et des LLM et, même si l’entreprise s’est montrée prudente au début, elle s’est finalement empressée d’intégrer des fonctionnalités reposant sur l’IA générative dans ses produits. Son nouveau moteur de recherche Search Generative Experience (SGE) intègre des instantanés générés par l’IA, un mode conversationnel accompagnant la recherche et des suggestions de questions complémentaires. Les inquiétudes relatives à la concurrence dans le domaine de la recherche se sont donc atténuées, mais des questions subsistent quant aux conséquences à court terme que pourrait avoir une plus large adoption de l’IA sur la monétisation et sur les coûts. En définitive, au vu du potentiel de nouvelles utilisations ne faisant traditionnellement pas partie de la recherche, l’IA semble constituer un véritable facteur d’expansion pour la recherche.

Pour ce qui concerne les autres franchises de Google, YouTube peut être considéré comme un bénéficiaire indirect de l’IA générative. Cela fait longtemps que cette plateforme utilise l’IA pour la recommandation et la modération de contenu, ainsi que pour le ciblage publicitaire, et les efforts déployés en ce sens devraient se poursuivre. Le principal impact de l’IA générative viendra sans doute de la démocratisation de la production de contenu médiatique de haute qualité, ce qui devrait avoir effet d’améliorer la qualité de la bibliothèque de contenu de YouTube. L’IA générative devrait également permettre aux annonceurs de produire plus facilement des contenus créatifs de meilleure qualité et plus personnalisés. Si l’impact est difficile à calculer, il permet toutefois d’accroître la confiance quant à la longueur de la piste d’atterrissage.

Google Cloud bénéficiera de l’IA générative d’une manière similaire à ce qui est le cas pour Microsoft. Google planche actuellement sur Duet (sa version de Copilot) qui devrait compléter Workspace (sa version d’Office). Vertex AI est une plateforme proposée sur Google Cloud et sur laquelle les clients peuvent concevoir, entraîner et faire tourner des modèles d’IA, y compris en accédant aux modèles LLM de base de Google. L’impact est difficile à estimer, mais il sera limité, car le Cloud ne représente actuellement qu’environ 11 % du chiffre d’affaires total de la société. Google Cloud a davantage été structuré autour de l’analyse du big data et l’IA devrait apporter une contribution marginale sur ce point.

L’IA aide les clients d’Adobe à se fier davantage aux solutions que propose le groupe

Cela fait déjà un certain temps qu’Adobe investit dans l’IA et l’apprentissage automatique. Le lancement, en 2016, de Sensei, son outil d’IA pour le marketing numérique, fournit, à cet égard, une excellente illustration des efforts déployés par le groupe dans ce domaine. L’année dernière, la majorité des clients d’Adobe utilisaient Sensei pour accélérer et simplifier leur flux de travail. Profils des clients, campagnes de marketing passées, données de vente, etc.: ce système intègre tous ces éléments afin de suggérer un mix de dépenses de marketing ou des expériences de marketing différenciées et d’optimiser ainsi la prise de décision. Et comme Adobe dispose d’une véritable abondance de données – élément qui constitue le carburant de toute ambition en matière d’IA –, la position de tout premier plan qu’occupe le groupe dans les différentes solutions constitue un avantage tout à fait distinctif sur le plan de la valeur ajoutée.

Ce cycle auto-réalisateur dans lequel se trouve Adobe du fait de la position de pointe qu’il occupe devrait permettre de maintenir la dynamique actuelle, notamment à un moment où le marketing se fait de plus en plus personnalisé et où les solutions et les plateformes de marketing nécessitent davantage de données, d’intégrations et d’IA. Des tendances similaires sont également à l’œuvre dans les autres segments d’Adobe où l’IA permet d’optimiser les capacités d’édition, de partage, de signature, etc. pour les utilisateurs du cloud de documents d’Adobe.

Enfin, le récent engouement dont l’IA générative fait l’objet se manifeste de manière encore plus évidente dans l’activité de création de contenu numérique d’Adobe. De fait, si les fonctions avancées de retouche photo ont toujours fait partie des standards incontournables, la nouvelle fonction Firefly permettant de générer des images à partir d’un texte, est, elle aussi, désormais en passe de devenir une fonctionnalité essentielle. Adobe a toujours fait preuve d’une rigueur particulièrement marquée dans le développement de l’IA, et toutes les fonctionnalités mises au point font l’objet d’un processus d’examen de leurs implications générales, y compris de celles ayant trait à l’éthique. Par ailleurs, et contrairement à d’autres applications de conversion de texte en image, Firefly n’est pas entraîné sur «tout» et fait preuve d’une prudence particulière en ce qui concerne les applications commerciales. Firefly commence par des images appartenant à Adobe Stock et n’ajoute du contenu sous licence ouverte et du contenu public que lorsque les droits d’auteur ont expiré. Cette approche peut être élargie au propre contenu créatif des clients. Même si des données commercialement utilisables et inutilisables peuvent certainement présenter des avantages pour la génération d’idées, l’objectif d’Adobe est avant tout, ainsi que l’indiquent les commentaires des utilisateurs, de permettre à ces derniers de disposer d’un contenu commercialement utilisable. Cette priorité accordée à l’expérience utilisateur constitue la base sur laquelle se fonde le débat sur l’ampleur et la rapidité de la monétisation. Adobe met actuellement l’accent sur l’augmentation du nombre d’utilisateurs et sur l’expansion de l’écosystème. Qu’elle contribue à la génération d’idées ou à la création de plus de contenus, l’IA permet aux utilisateurs d’accroître leur productivité et les poussent, en définitive, à recourir davantage aux solutions d’Adobe.

Processeurs graphiques (GPU), puces mémoire et fonderies: les composants semi-conducteurs constituent des piliers essentiels de l’avancée de l’IA

Le coût des serveurs d’IA est environ 15 à 32 fois plus élevé que celui des serveurs ordinaires (7 000 USD); cela tient essentiellement à l’augmentation des prix du silicium et à des exigences plus élevées quant aux spécifications matérielles requises. Du fait, notamment, du recours à des unités centrales (CPU) haut de gamme, à des GPU supplémentaires et de l’accroissement des exigences requises en ce qui concerne les puces mémoire, les semi-conducteurs représentent 90 % du coût matériel des serveurs d’IA (contre 65 % pour les serveurs ordinaires).

La question des semi-conducteurs semble en grande partie décorrélée de la question de savoir quelle société bénéficie le plus de l’IA. Pour préciser notre pensée à ce sujet, il nous semble que les investisseurs se sont moins intéressés aux acteurs de la fonderie et de la mémoire parce que ces derniers sont, pour la plupart, implantés dans des marchés émergents où le risque géopolitique est élevé et où la forme que peut prendre le cycle des semi-conducteurs suscite des inquiétudes.

TSMC, acteur clé de la fonderie pour l’IA générative et les capacités de calcul informatique de pointe

Le rôle que joue la société Taiwan Semiconductor Manufacturing Company (TSMC) en tant que fabricant de puces polyvalent lui permet de réaliser des gains réguliers à l’échelle de tout le secteur, et ce, indépendamment du succès de quelque société que ce soit opérant dans le domaine de l’IA (qu’il s’agisse de Google, de Microsoft ou de toute autre société). Quelle que soit l’architecture de puces mise en œuvre pour l’IA et dominant le marché (ASIC sur mesure ou GPU à usage général), TSMC sera le fournisseur indispensable de solutions de calcul informatique de pointe.

La solidité du modèle d’activité de TSMC non seulement isole le groupe des risques associés au succès des produits de quelque société d’IA particulière que ce soit, mais le positionne également de manière favorable pour engranger des gains quantifiables et évolutifs au fur et à mesure que la demande de puces capables de fonctionner avec l’IA augmentera.

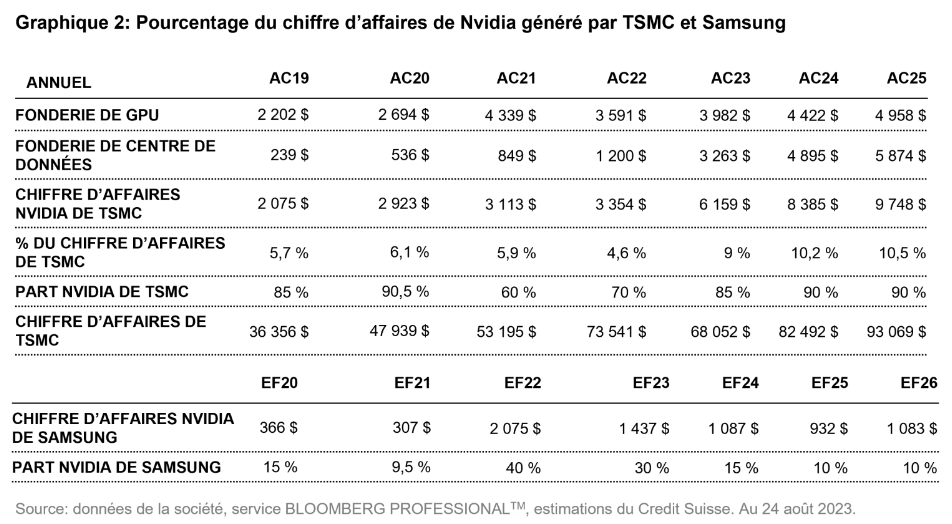

Bien que les définitions puissent varier à ce sujet, la chaîne d’approvisionnement technologique définit généralement les serveurs d’IA comme ceux qui sont équipés de GPU. Or, compte tenu des difficultés et des coûts élevés associés au passage à d’autres fonderies, TSMC est le seul fondeur des GPU destinés aux centres de données de Nvidia et d’Advanced Micro Devices. Enfin, TSMC est également susceptible de bénéficier de l’adoption croissante de solutions d’inférence moins coûteuses, ce qui pourrait avoir pour effet, à terme, d’entraîner une augmentation des volumes unitaires et, par là même, de dynamiser la consommation de plaquettes de pointe.

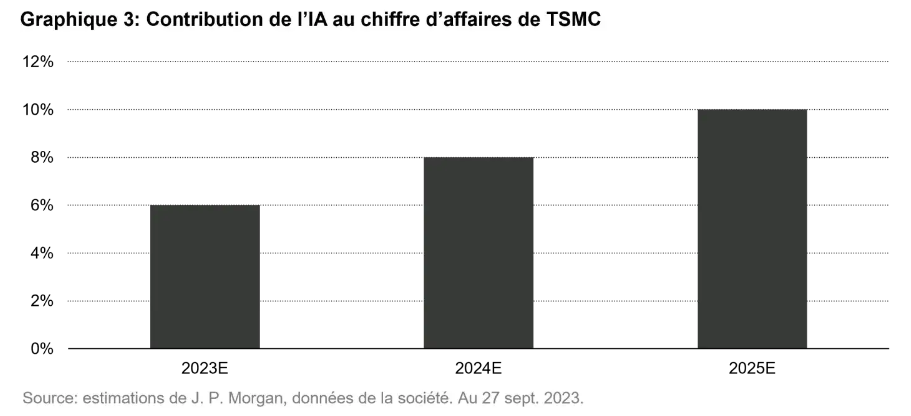

L’exposition du chiffre d’affaires de TMSC lié à l’IA est de 6% et devrait afficher un taux de croissance annuel composé (TCAC) de 50% au cours des cinq prochaines années, pour atteindre une contribution au chiffre d’affaires de l’ordre de plus ou moins 15%. Le président de TSMC a récemment indiqué que l’entreprise n’était actuellement en mesure de répondre qu’à 80% de la demande de ses clients en matière de solutions de conditionnement avancées de circuits intégrés «Chip-on-Wafer-on-Substrate» (CoWoS) pour les puces d’IA. Il estime que l’offre ne pourra répondre à la demande que dans un an et demi. TSMC reste le fournisseur des solutions d’IA pour les centres de données grâce à sa technologie de procédés, à ses capacités de conditionnement CoWoS, à la qualité de son rendement dans le domaine des puces de grande taille et à la solidité de son écosystème de conception (et devrait détenir une part de 90% sur le marché des accélérateurs d’IA).

Samsung Electronics: une solution à guichet unique pour les clients des serveurs d’IA

Tout serveur d’IA doit permettre de multiplier par 10 le contenu de la mémoire vive dynamique (Dynamic Random Access Memory, DRAM) grâce à la mémoire à haute bande passante (high bandwidth memory, HBM), un composant essentiel pour faire fonctionner les processeurs d’entraînement à l’IA grâce à une latence plus faible et à une moindre consommation d’énergie. Les modèles d’IA ne valent que ce que valent les données que la DRAM injecte dans les processeurs, car l’accélération du calcul nécessite une étroite intégration des GPU/ASIC avec la mémoire à haute bande passante (HBM)3. La DRAM constitue l’un des composants à plus forte valeur ajoutée dont la croissance soit structurelle dans le domaine de l’IA. Alors que nous anticipions une hausse de la demande de DRAM pour serveurs à un taux de croissance de plus ou moins 15%, l’émergence de l’IA a entraîné une augmentation de 10 points du TCAC, ce qui a généré une demande totale supplémentaire de DRAM de 3 à 4%.

Pour Samsung, la mémoire HBM devrait représenter plus de 10 % des ventes de DRAM en 2024, ce qui est à mettre en regard d’un taux à un chiffre moyen à élevé au premier semestre 2023. Samsung et Sk hynix anticipent une croissance de la demande de serveurs d’IA de 35 à 40% au cours des cinq prochaines années, et tablent sur une croissance du marché HBM de plus de 60% sur la même période4. Samsung estime par conséquent que la demande de mémoire pour les accélérateurs d’IA devrait atteindre 11% de la demande totale de DRAM à l’horizon 2028. Le groupe Samsung propose une solution à guichet unique aux clients de serveurs d’IA, car il a la capacité de fabriquer les composants nécessaires pour les puces de serveurs d’IA, notamment en ce qui concerne les GPU (fonderie), la mémoire HBM (mémoire DRAM) et le conditionnement avancé.

Accenture a mis en place une solide base de compétences et de solutions en matière d’IA.

L’assise dont bénéficie Accenture dans le domaine de l’IA s’est matérialisée tout à la fois par une croissance organique et par la réalisation d’acquisitions stratégiques. Outre sa connaissance approfondie de certains secteurs d’activité et processus d’entreprise, le groupe possède également de solides atouts en matière de conseil, de conception de solutions et de développement d’applications sur mesure. Connu pour son approche personnalisée et sa faible dépendance à l’égard du codage, le conseil aux entreprises est moins susceptible de se transformer en un service générique et standardisé. Enfin, Accenture a déployé une plateforme d’automatisation informatique pilotée par l’IA sur laquelle peuvent s’appuyer ses modèles opérationnels et de prestation de services.

Le groupe entend investir 3 milliards de dollars dans l’IA au cours des trois prochaines années et il prévoit de doubler ses effectifs dans le domaine de l’IA pour atteindre un effectif de 80 000 personnes, car il anticipe une adoption plus rapide que celle du Cloud. Accenture a souligné à quel point la mise en œuvre de l’IA à grande échelle pouvait se révéler complexe, notamment en ce qui concerne l’IA générative, car moins de 10 % des clients (selon les estimations du groupe) disposent de la pile technologique appropriée pour tirer parti de cette technologie.

Cette année, Accenture a généré des projets d’IA générative dont la valeur approximative s’élève à près de 300 millions de dollars. Ces missions demeurent très modestes et exploratoires (sur un chiffre d’affaires d’environ 64 milliards de dollars en 2023), mais l’expérience précoce dont dispose le groupe dans ce domaine lui permet de renforcer sa proposition de valeur pour chaque projet supplémentaire, qu’il s’agisse d’une nouvelle migration vers le Cloud ou d’une optimisation du stockage des données.

Comprendre les risques

Lorsqu’il s’agit d’évaluer les capacités de calcul informatique dans le domaine de l’IA, les risques peuvent notamment résider dans une adoption moins importante que prévu de l’IA, dans des modèles de moindre envergure, dans des volumes de données d’entraînement moindres et dans une conception optimisée du modèle et de l’algorithme susceptible de réduire les exigences en matière de capacités de calcul informatique. Les préoccupations concernant la vie privée, la sécurité, la conformité et l’infrastructure des données constituent les principaux éléments susceptibles de faire obstacle à l’adoption de l’IA. Il existe également un risque de cannibalisation. Sans une monétisation rapide des applications d’IA, ceux que l’on appelle les «hyperscalers», c.-à-d. les grands fournisseurs de services Cloud proposant des services de calcul informatique et de stockage à l’échelle de l’entreprise, pourraient encore décider de plafonner leurs dépenses sur les serveurs traditionnels ou les coûts d’exploitation (effectifs, p. ex.). Même si nous ne savons pas pendant combien de temps ni à quel point la cannibalisation des budgets aura un impact sur la demande générale de serveurs, il nous semble néanmoins que, à long terme, l’IA devrait également stimuler la demande portant sur les centres de données. Enfin, les capacités de conditionnement CoWoS (conditionnement en aval) constituent, pour l’heure, le principal goulot d’étranglement, et TSMC devra, pour l’éliminer, doubler sa capacité en 2024 par rapport au niveau actuel afin de pouvoir répondre à la croissance de la demande.

Adopter une approche Quality Growth pour investir dans l’IA

Même si des changements révolutionnaires semblent pouvoir se produire du jour au lendemain dans le domaine de l’IA, il faut parfois beaucoup de temps pour que des applications pratiques finissent pas se concrétiser. À court terme, le marché pourrait ainsi surestimer le potentiel de certaines sociétés et le potentiel disruptif que présente l’IA pour d’autres. Nous sommes fermement déterminés à poursuivre nos recherches sur l’IA générative, et nous anticipons à ce sujet que les participations de nos portefeuilles comptent tout autant d’utilisateurs que de bénéficiaires. L’IA a suscité un véritable engouement et un formidable espoir d’assister à une explosion de la croissance pour les sociétés de matériel informatique axées sur l’augmentation de la capacité des serveurs, et ce, alors que les activités de ces sociétés ont tendance à être plus capitalistiques et cycliques et, par là même, plus volatiles. Nous recherchons des sociétés présentant une croissance des bénéfices qui soit prévisible et durable et bien positionnées pour bénéficier des évolutions structurelles actuellement à l’œuvre.

1. Les grands modèles de langage (LLM) constituent un véritable bond en avant quant aux capacités qu’ont les ordinateurs à comprendre le langage grâce à l’apprentissage des définitions des mots et des règles de grammaire.

2. Pour Microsoft, le chiffre d’affaires de l’IA pourrait atteindre les 20 milliards de dollars: env. 11 milliards pour Office, env. 1 milliard pour GitHub, env. 2 milliards pour d’autres produits Copilot et env. 6 milliards pour Azure.

3. HBM: mémoire haute performance (architecture DRAM empilée dans une structure 3D) offrant une haute bande passante et nécessitant moins d’énergie pour déplacer les données. La mémoire HBM fonctionne comme une autoroute très large laissant passer plus de données à la fois, et ce, en consommant moins d’énergie, ce qui constitue un véritable atout, car cela permet d’économiser de l’énergie.

4. La demande de serveurs d’IA devrait afficher un TCAC de 35 à 40% et la croissance du marché HBM devrait, elle, enregistrer un TCAC de plus de 60%.

Le présent document est fourni uniquement à des fins d’information et son contenu ne constitue en aucun cas une sollicitation, offre ou recommandation d’achat ou de vente d’instruments de placement, de réalisation de transactions ou de conclusion d’actes juridiques, de quelque nature qu’ils soient. Les décisions prises sur la base des informations contenues dans ce document relèvent de la seule responsabilité du lecteur. Vous ne devez pas vous fier seulement aux informations contenues dans le présent document au moment d’investir ou pour toute autre décision. Le présent document n’a pas été rédigé en tenant compte de la situation particulière de chaque investisseur. Toute projection, déclaration prospective ou estimation contenue dans le présent document est spéculative. En raison des risques et incertitudes variés, il est impossible de garantir que les estimations ou hypothèses formulées se révéleront exactes, et les événements et résultats effectifs peuvent différer sensiblement de ceux présentés ou attendus dans le présent document. Les opinions exprimées dans le présent document sont susceptibles de changer selon les conditions de marché, économiques ou autres. Les informations du présent document doivent être interprétées non pas comme une recommandation, mais comme une illustration d’enjeux économiques plus généraux. La performance passée ne constitue pas un indicateur fiable de la performance actuelle ou future. Le rendement d’un investissement peut baisser ou augmenter, par exemple en raison des fluctuations des taux de change entre les devises. La valeur de l’argent investi dans un fonds peut augmenter ou diminuer et rien ne garantit que le capital que vous avez investi pourra être remboursé en tout ou en partie.